🩷 방문자 추이

🏆 인기글 순위

티스토리 뷰

[hadoop] 1. ubuntu 18.04에 하둡(Hadoop) 설치하기

https://domdom.tistory.com/524

[hadoop] 2. 로컬에 있는 파일을 HDFS에 전송하기

https://domdom.tistory.com/525

[hadoop] 3. apache hadoop 위에 spark 설치하기

https://domdom.tistory.com/526

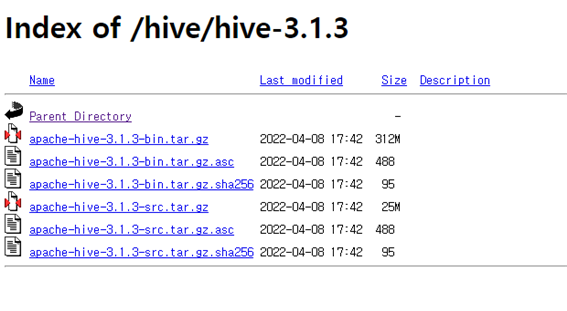

1. 아파치 하이브 다운로드 사이트에 들어가서 최신버전을 wget을 통해 다운받습니다

https://dlcdn.apache.org/hive/

Index of /hive

dlcdn.apache.org

wget https://downloads.apache.org/hive/hive-3.1.2/apache-hive-3.1.2-bin.tar.gz

2. 다운받은 압축파일을 압축해제해줍니다.

tar xzf apache-hive-3.1.3-bin.tar.gz

3. 환경 변수를 설정합니다.

vi ~/.bashrc

맨 아래에 HIVE 관련 환경변수를 입력해주세요.

export HIVE_HOME="/root/apache-hive-3.1.3-bin"

export PATH=$PATH:$HIVE_HOME/bin

환경변수를 적용시켜줍니다.

source ~/.bashrc

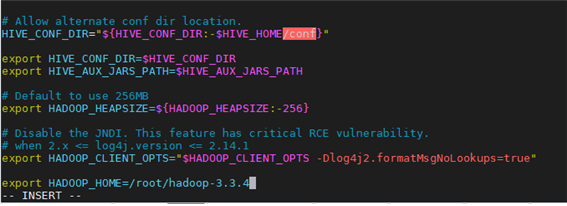

4. hdfs와 hive의 상호작용을 위해 hive-config.sh 파일을 수정합니다.

맨 아래 줄에 HADOOP_HOME 변수를 입력해줍니다,

vi $HIVE_HOME/bin/hive-config.shexport HADOOP_HOME=/home/hdoop/hadoop-3.3.4

5. hdfs에 hive 관련 디렉토리를 만들어줍니다.

hive라는 디렉토리를 만들어주고, 쓰기 실행 권한을 부여해줍니다.

hdfs dfs –mkdir /hive

hdfs dfs -chmod g+w /hive

6. hive와 관련된 테이블을 저장하는 warehouse 디렉토리도 만들어줍니다.

hdfs dfs -mkdir –p /user/hive/warehouse

hdfs dfs -chmod g+w /user/hive/warehouse

7. hive-default.xml.template 파일을 설정합니다.

hive-default.xml.template 파일을 복사하여 configuration 안에 아래의 property를 추가합니다.

cd $HIVE_HOME/conf

cp hive-default.xml.template hive-site.xml

vi hive-site.xml<property>

<name>system:java.io.tmpdir</name>

<value>/tmp/hive/java</value>

</property>

<property>

<name>system:user.name</name>

<value>${user.name}</value>

</property>

그리고 javax.jdo.option.ConnectionURL의 value 부분을 아래와 같이 수정해주세요.

jdbc:derby:/root/apache-hive3.1.3-bin/metastore_db;databaseName=metastore_db;create=true

8. 이제 derby database 를 시작합니다.

$HIVE_HOME/bin/schematool -initSchema –dbType derby명령어를 입력하면 아래와 같이 complated가 뜹니다.

9. hive를 실행해봅니다.

$HIVE_HOME/bin/hive

정상적으로 실행되는 것을 확인했습니다!

'개발환경 > Server' 카테고리의 다른 글

| [Linux] curl을 이용한 GET/POST/JSON/파일업로드/명령어결과 전송 방법(cheatsheet) (0) | 2022.11.20 |

|---|---|

| [hadoop] 5. apache hadoop to postgreSQL 가능한 sqoop 설치하기 (0) | 2022.11.16 |

| [hadoop] 3. apache hadoop 위에 spark 설치하기 (0) | 2022.11.13 |

| [hadoop] 2. 로컬에 있는 파일을 HDFS에 전송하기 (0) | 2022.11.12 |

| [hadoop] 1. ubuntu 18.04에 하둡(Hadoop) 설치하기 (1) | 2022.11.11 |