🩷 방문자 추이

🏆 인기글 순위

티스토리 뷰

[hadoop] 1. ubuntu 18.04에 하둡(Hadoop) 설치하기

https://domdom.tistory.com/524

[hadoop] 2. 로컬에 있는 파일을 HDFS에 전송하기

https://domdom.tistory.com/525

이번에는 하둡 위에 apache spark를 설치해보려합니다.

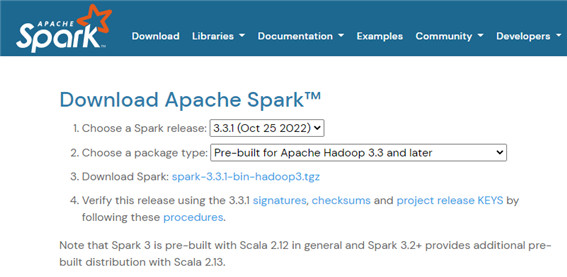

1. 아파치 스파크 다운로드 사이트에 들어가서 최신버전을 wget을 통해 다운받습니다

하둡과 버전을 맞추어서 설치해주세요.

wget https://dlcdn.apache.org/spark/spark-3.3.1/spark-3.3.1-bin-hadoop3.tgzhttps://spark.apache.org/downloads.html

Downloads | Apache Spark

Download Apache Spark™ Choose a Spark release: Choose a package type: Download Spark: Verify this release using the and project release KEYS by following these procedures. Note that Spark 3 is pre-built with Scala 2.12 in general and Spark 3.2+ provides

spark.apache.org

2. 다운받은 압축파일을 압축해제해줍니다.

tar xvzf spark-3.3.1-bin-hadoop3.tgz

3. 심볼릭 링크를 생성합니다.

ln -s spark-3.3.1-bin-hadoop3 spark

4. .bashrc파일에 환경변수를 설정해줍니다.

JAVA 경로 및 스파크 경로를 입력해주면 됩니다.

vi ~/.bashrcexport SPARK_HOME="/root/spark-3.3.1-bin-hadoop3"

export PATH=:$PATH:/usr/lib/jvm/java-8-openjdk-amd64/lib/tools.jar:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:/root/spark/bin

환경변수 설정을 적용합니다.

source ~/.bashrc

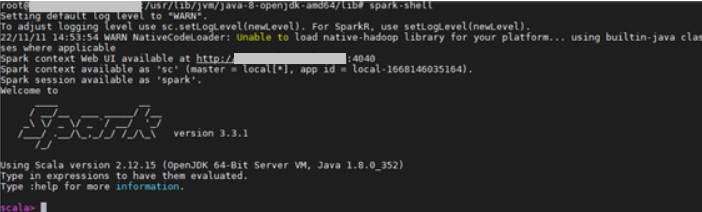

5. apache spark-shell, spark-sql을 실행해봅니다.

아래와 같이 출력되면 설치가 정상적으로 완료된 것입니다.

spark-shell

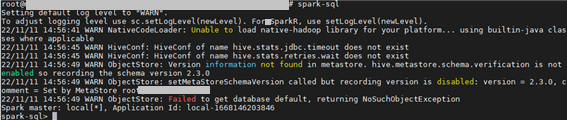

이번엔 spark-sql을 실행시켜봅니다.

이번엔 pyspark를 실행시켜봅니다.

이렇게하면 하둡 위에 스파크 설치 끝!

'개발환경 > Server' 카테고리의 다른 글

| [hadoop] 5. apache hadoop to postgreSQL 가능한 sqoop 설치하기 (0) | 2022.11.16 |

|---|---|

| [hadoop] 4. apache hadoop hdfs와 상호작용하는 hive 설치하기 (0) | 2022.11.14 |

| [hadoop] 2. 로컬에 있는 파일을 HDFS에 전송하기 (0) | 2022.11.12 |

| [hadoop] 1. ubuntu 18.04에 하둡(Hadoop) 설치하기 (1) | 2022.11.11 |

| [java] ubuntu 18.04에 java 8 설치하기 (0) | 2022.11.11 |